58 KiB

sion# CFN Overview & Use Case Exploration

Versions:

| Version | Date |

|---|---|

| 0.5 | June, 2023 |

| 1.0 | November, 2023 |

Contributors: Jianchao Guo (AsiaInfo), Jian Xu (China Mobile), Jie Nie (China Mobile), Jintao Wang (China Mobile), Lei Huang (China Mobile), Qihui Zhao (China Mobile), Weiguo Hu (99Cloud), Weisen Pan (China Mobile), Xiaoqiao Geng (Inspur), Yong Chen (Nokia), Yongfeng Nie (Huawei), Zhihua Fu (H3C)

1. Introduction

近年来,在政策牵引、技术创新和需求导向的多重驱动下,数字经济发展速度之快、辐射范围之广、影响程度之深前所未有,正在成为重组全球要素资源、重塑全球经济结构、改变全球竞争格局的关键力量。在数字经济时代,全球数据总量和算力规模继续呈现高速增长态势,2021年,全球计算设备算力总规模达到615EFlops,增速达到44%,其中基础算力规模为369EFlops,智能算力规模为232EFlops,超算算力规模为14EFlops;2030年,人类将迎来YB数据时代,全球算力规模达到6ZFlops,平均年增速达到65%,其中,基础算力达到3.3ZFlops,平均年增速达27%;智能算力达到52.5ZFlops,平均年增速超过80%;超算算力达到0.2ZFlops,平均年增速超过34%。与此同时,AI、元宇宙等新型领域的崛起,更加推动了全球算力规模的快速增长,驱动计算技术与产品的多元创新,带动产业格局的重构重塑。算力作为数字经济时代新的生产力,其重要性被提升到了新的高度,成为支撑数字经济发展的坚实基础、全球经济发展的重要引擎,对推动科技进步、行业数字化转型以及经济社会发展发挥重要作用。

而随着算力的持续快速发展,也面临着应用多元化、供需不平衡等一系列挑战,而无处不达的网络,为算力的分层分布和算力间的深度协同奠定了基础。在此背景下,算力网络应运而生,算力网络就是把分散部署的泛在算力,与无处不在的全域网络资源进行互联,使应用能按需、实时调用不同地域的计算资源,通过最佳的资源分配方案实现资源的最优使用,为千行百业提供像“自来水”一样即取即用、触手可达的算力服务。未来,算力网络会像今天的电网、通信网和高铁网一样,成为数智化时代的新型基础设施,为为全球数字经济发展提供强劲动力。

本文将从用户角度解读算力网络概念、梳理当前业界算力网络的进展、分析算力网络的主要应用场景,并提出构建算力网络存在的问题与挑战,从而针对如何进一步推动算力网络的加速成熟,以及实现算力网络社会级服务的最终愿景提出建议。

2. What is computing force network from user perspective

2.1 Concept of computing force network

“算力网络”是近年来产业界的热点,目前人们对算力网络的概念、定义和范畴的理解还不完全统一,但也存在一些相对主流且相似的定义:

- 中国移动《算力时代》一书中定义“算力网络是以算为中心、网为根基,网、云、数、智、安、边、端、链(ABCDNETS)等深度融合、提供一体化服务的新型信息基础设施。算力网络的目标是实现‘算力泛在、算网共生、智能编排、一体服务’,逐步推动算力成为与水电一样,可‘一点接入、即取即用’的社会级服务,达成网络无所不达、算力无所不在、智能无所不及的愿景”,侧重描述算力网络是一项融合基础设施,计算能力是核心、网络接入是基础、即取即用是效果。

- 中国电信在《云网融合2030技术白皮书》中定义“算力网络是一种利用网络控制面传递算力等资源信息,并以此为基础实现多方、异构的计算、存储、网络等资源之间的信息关联与高频交易的技术体系,以满足新兴业务提出的‘随时、随地、随需’的多样化需求,从而解决不同类型云计算节点规模建设后的算力分配与资源共享需求难题”,指出算力网络是技术体系,是网络与大规模云计算节点的融合,目的是提供灵活的算力分配和资源共享。

- 中国联通提出以网为中心实现算力网络,在《中国联通算力网络白皮书》中认为“算力网络的出现是为了提高端、边、云三节计算的协同工作效率”,通过算力网络保证智能机器的高效工作和快速响应,以便支撑智能机器更好的服务人类。

综合解读上述定义,算力网络是一种新型信息基础设施,其最为核心的基础能力是算力和网络。其中,算力是指遍布在云、边、端等地理位置的分布式、泛在化的计算能力,可来源于云计算节点、边缘计算节点、终端设备、网络设备等,为信息数据处理提供基础;网络是指包含光接入网络、光传输网络、IP网络、SDN、确定性网络等在内的高速互联、高效可靠的网络能力,可为用户、数据、算力的互联提供保障。 除基础能力之外,算力网络的主要特点将计算和网络深度融合,通过无处不在的网络把分散部署的多样算力资源互联,并通过集中控制或者分布式调度等方法将计算资源、存储资源、网络资源、安全资源等进行协同,动态实时感知算力资源状态和位置,统筹分配和调度计算任务、传输数据,使海量的应用能够按需、实时调用不同地域的计算资源,从而保证为用户提供平等共享、精准匹配、位置无感、按需弹性的算力服务。

从技术角度看,算力网络并不是某项单点技术的创新,它是在现有的孤立的计算、存储、网络、安全等基础设施之上,通过对资源进行纳管、整合、调配、重优化等一系列措施实现算力即服务(CaaS,Computing as a Service)。它更多的是理念创新、商业模式创新、生态创新。类似SDN概念出现的时候,也是对网络的一个理念创新,而并没有大的网络技术的革命。它与云计算的终极目标类似,将在当前云计算简单地以CPU数量、GPU数量、网络带宽、存储容量等为单位的资源式交互服务模式之上,向任务式交互服务模式演进,进一步向用户屏蔽后端算力及网络的复杂度。因此,算力网络更多是计算和网络的融合,打破以前两者的壁垒,让用户不用关心提供算力服务的具体硬件形态、物理位置等,而更聚焦于任务执行本身。算力网络虽然名称上以网络结尾,但其实在内涵上是以计算为中心的。

2.2 Capability type of computing force network

由于算力网络以计算为中心,本节将首先从几个不同的维度对算力分类。其他算力网络能力的分析将在后续逐步更新完善。

- 根据算力类型的不同,可以将算力分为通用算力和专用网络:

- 通用算力: 由基于X86架构、ARM架构的CPU芯片组成,主要用于基础通用计算,可处理多样化算力任务,灵活性较强但功耗较高。通用算力占整体算力的比重由2016年的95%下滑至2020年的57%,虽然通用算力未来仍会是主要算力类型之一,但其比例会进一步减少。

- 专用算力:

- 智能算力: 由GPU、FPGA、ASIC等AI芯片构成的算力,主要用于人工智能的训练和推理计算,比如语音、图像和视频的处理。在技术架构上,人工智能的核心计算能力由训练、推理等专用计算芯片提供,注重单精度、半精度等多样化计算能力。在应用方面,人工智能计算中心主要支持人工智能与传统行业的融合创新与应用,提升传统行业的生产效率,在自动驾驶,辅助诊断、智能制造等方面作用显著。智能算力规模近年增长迅速,在整体算力中的占比已由2016年的3%提升至2020年的41%,预计截止今年(2023)智能算力的占比将提升至70%。

- 超算算力: 由超级计算机等高性能计算集群构成的算力,主要用于尖端科学领域的计算,比如行星模拟、药物分子设计、基因分析等等。在技术架构上,超算的核心计算能力由高性能CPU或协处理器提供,注重双精度通用计算能力,追求精确的数值计算。在应用方面,超算中心主要应用于重大工程或科学计算领域的通用和大规模科学计算,如新材料、新能源、新药设计、高端装备制造、航空航天飞行器设计等领域的研究。超算算力在整体算力中的占比较为稳定,约为2%。

- 根据算力位置/算力来源的不同,可分为超算中心算力、智算中心算力、公有云算力、网络云算力、私有云算力、边缘算力、终端算力等:

- 超算中心算力: 由超算中心提供的算力,一般指高性能CPU算力。

- 智算中心算力: 由智算中心提供的算力,一般指GPU、DSA、FPGA等AI领域算力。

- 公有云算力: 由公有云提供的算力,一般包含通用能力和以GPU为主的专用能力。

- 网络云算力: 由运营商在网络功能虚拟化(NFV)之后构建的网络云数据中心提供的算力,该类算力一般专用于部署电信类网元(如5GC、IMS、EPC、音视频网元等)、MANO系统、网管系统等。由于网络云有超高的安全性、可靠性等要求,因此封闭性较强,如何使用网络云为算力网络提供算力仍需探索。

- 私有云算力: 由企业内部数据中心提供的算力,该类算力多用于部署企业专用的软件,比如企业OA系统、工业管理系统、开发环境等。是否可使用私有云为算力网络提供算力需根据企业安全性要求灵活确定,可能存在无法提供算力、可在特殊安全隔离要求下提供算力等多种情况。

- 边缘算力: 边缘算力是对公有云、网络云等相对集中的云计算算力的补充。其单点算力数量较少、计算能力较弱,但分布广、数量多,可来源于网关、路由器、交换机、边缘云、边缘计算服务器等。此外,边缘算力类型差异大,可由CPU、GPU、FPGA等多种异构计算芯片构成。该类算力多用于支撑部署在边缘的应用完成计算任务,包括但不限于人工智能推理类应用、视频处理等。将边缘算力纳入算力网络面临灵活调度、高效管理、稳定支撑等方面的挑战。

- 终端算力: 由PC、手机、平板、VR设备等个人设备提供的算力,其计算能力更小、位置分布更散、数量更多。如果使用这类算力也是个难题。

当前,因技术、安全等各方面因素,算力网络将优先考虑协同来源于超算中心、智算中心、公有云、边缘云的算力,其他算力可逐步纳入。

2.3 Service pattern of computing force network

如2.1节所述,算力网络向用户提供算力即服务(CaaS,Computing as a Service),有着与云计算相似的算力内核,因此算力网络服务模式可类比云计算服务模式分为以下三类:

- 资源型服务

算力网络资源型服务类似于现在公有云提供的云主机、云硬盘以及云网络等直接算力服务。这类服务的特点是对于算力网络管控系统来说,只需要完成资源调配工作,不用关心用户如何使用算力。用户往往需要通过portal界面或控制台来完成这类服务的申请和开通。当然和公有云不同的是,算力网络可能对接不同厂商不同形态的云或边缘算力。另外,这类资源性服务有可能需要创建访问算力的广域网路径,即需要保证用户访问算力的网络质量。当然用户也可能通过公共互联网来访问,这取决于用户的需求。

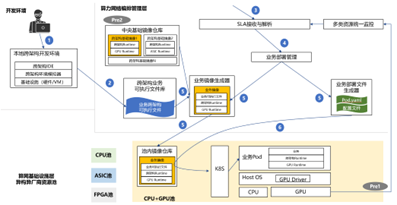

- 平台型服务

算力网络平台型服务是类似于PaaS的间接算力服务模式,由算力网络系统帮助用户去部署其自主开发的应用,然后运行用户应用,并监控应用的运行过程,同时还可以提供应用访问、扩缩容等功能。这种服务类似于Kubernetes,通过对容器的编排和管理实现平台即服务(PaaS)。在实现这类服务时,算力网络实际底层还是需要基于其纳管的算网资源来进行调度、编排、部署等,用户还需要关注其业务逻辑。

- 应用型服务

算力网络应用型服务类似于现在公有云提供的SaaS服务模式,一般指用户来通过服务商平台选择一个具体的应用服务,算力网络为用户部署应用,用户可通过API访问应用服务,无需关注系统、软件、部署位置等细节。

- 任务型服务

任务型服务(Task as a Service)是算力网络最智能最理想的服务类型。用户仅需向算力网络提供对任务的描述性说明(如“需要在靠近学校A的位置部署一套视频监控类业务”),算力网络服务商可理解用户需求(如业务类型、服务质量、可靠性、安全、成本等需求)、自主灵活选择算力中心、选择适合业务场景的业务,部署并配置好业务后向算力网络管控平台注册应用实例的资源及业务信息等,定期上报应用状态更新。算力网络需要感知应用实例的位置和状态,生成访问这些应用的路由策略并向网络中的路由节点下发。路由节点收到访问应用的报文后根据下发的路由策略进行转发。这些策略往往需要综合考虑应用的算力状态和网络状态,以此做出最优决策。当然,应用的感知和路由策略生成也可以由网络节点自行完成。

2.4 Computing force network VS Integrated cloud and network

由于“算力网络”与“云网融合”的核心基础能力都是算力和网络,两者常常被联合比较,甚至作为等同概念被提及,本节分析两者的异同点。

整体而言,“算力网络是对云网融合的深化和新升级,云网融合是算力网络的初级阶段。云网融合在内涵上、阶段上、影响范围上都是算力网络的一个子集”。详细区别可从以下几点来看:

- 区别1:算力是核心,但来源不同。 算力网络中的算力来源更丰富,算力的提供方不再是专有的某几个数据中心或集群,理想情况下可来源于任何具备计算能力的设备,包括但不限于云数据中心、网络设备、终端设备、超算中心、智算中心等,并通过云边端的形式将泛在的算力通过网络化的方式连接在一起,实现算力的高效共享。而云网融合中的算力主要来源于云数据中心。

- 区别2:网络是基础,但与算力的协同方式不同。 对于云网融合而言,算力和网络分工界面比较简单,通过一个网关就可以由算关联到网。而对于算力网络,算力和网络可能多点、多次交互,两者的协同不再是通过分离的网络管理组件和算力管理组件。从算力服务商的角度来看算网应具备结构化特征。以应用型服务为例,①用户向算力网络提出应用的SLA、可靠性、安全性需求;②算力网络将负责将此类描述性需求转变为显性结构化需求,对应的,高质量SLA需要泛在算力结合确定性网络组成特定结构,高可靠需要位置相关的特定冗余结构,高安全可能需要使用虚拟网络隔离等结构;③最后算力网络应当按照结构化的、完整的需求进行资源发现、编排和调度。

- 区别3:算力和网络边界不同。 算力网络中的算力逐步走出云传统上的封闭边界,与网络广泛附着,从贯通云、网的端到端网络视角,相当于在网内也有算力的存在。此外,网络设备中存在的少量算力也可以被用以数据处理。

- **区别4:运营服务模式不同。**云网融合通常将计算和网络资源视为独立的资源进行优化、调度并对外提供服务。而在算力网络中,计算和网络资源被视为一个整体进行优化和调度,可以更好地满足复杂的业务需求,如服务质量、可靠性、安全性等。同时算力网络也需要开发新的应用服务模式和架构,以更好地适应其计算和网络资源的分布式和泛在特性。

3. Related study area of computing force network

在中国移动《算力网络白皮书》中,将算力网络体系划分成了3层,包含运营服务层、编排管理层、算网基础设施层。其中,算网基础设施层主要提供泛在的算力基础设施(用以满足中心级、边缘级、现场级的算力需求)和高效的网络基础设施(用以支撑用户灵活通过网络接入泛在算力);编排管理层是算力网络的调度中心,算网大脑是编排管理层的核心,整体向下实现对算网资源的统一管理、统一编排、智能调度、全局优化等,向上提供算网调度能力接口,支撑算网络多的多元化服务;服务运营层是面向用户的服务层,一方面可基于底层算网资源形成多种业务向用户提供算网服务,另一方面可与其他算力供应商协同构建统一的交易服务平台,提供“算力电商”等新型商业模式。

(如想了解更多图谱中具体的技术领域,可参见中国移动《算力网络白皮书》、《算力网络技术白皮书》)

上图是中国移动提出的算力网络技术图谱,其中罗列了相关技术研究领域,并将各领域归类到不同层级。图中,算网基础设施层中的算力基础设施和网络基础设施中涉及到的技术领域与云计算和网络发展相关技术领域并无显著区别,进而说明算力网络在底层基础技术上并不是全新的技术领域,而是基于已有技术领域的演进。此外,算网基础设施层中的算网一体部分是算力和网络融合关键,也是算力网络实现任务式交互服务模式的最核心保障技术,此部分可基于算网进行创新。图中的编排管理层和服务运营层将会产生大量商业模式、服务模式、管理模式的创新,是未来算力网络服务商商业竞争力的体现。

本文暂不涉及图中技术领域实现过程中的总体软件架构、技术选型等,相关内容后续将在本工作组的多个子工作组中展开讨论。

4. Use Cases

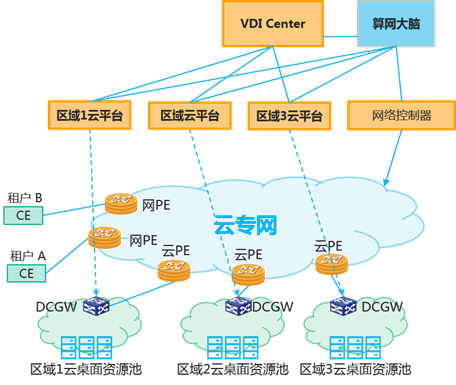

4.1 基于算网融合的VDI云桌面

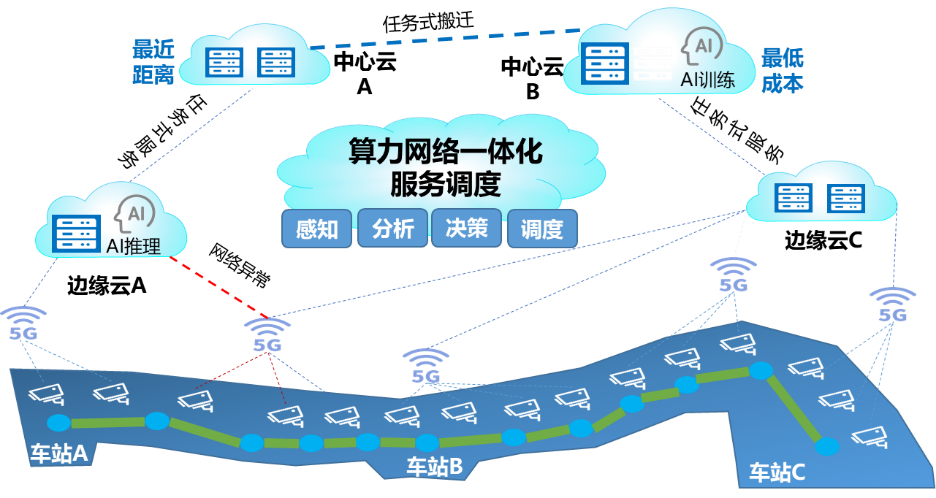

4.2 基于AI的算力网络流量控制与算力匹配

4.3 算力网络视频调度

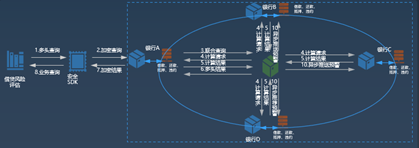

4.4 基于多方安全计算的借贷风险评估

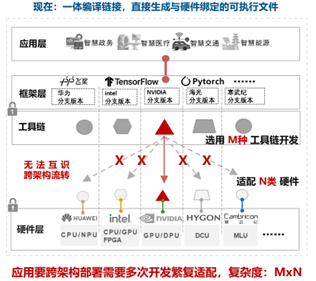

4.5 基于算力网络的AI应用跨架构部署迁移

4.6 算力网络裸金属管理

5. Next Step

本文分析了算力网络的热门定义、主要能力类型、服务模式、技术领域、应用场景等。为进一步细化算力网络实现,像业界提供更为具象的算力网络参考,后续我们计划依托CFN WG-需求与架构子工作组进一步完成应用场景分类,选择重点应用场景梳理算力网络基础功能架构,并与CFN WG其他子工作组协同形成特定场景解决方案。

6. Events about CFN

算力网络相关标准组织动态

- 2019年2月,互联网研究任务组(IRTF)在COIN(Computing In Network) 研究组中开始孵化CFN,致力于研究计算和网络的深度融合,改善网络、应用程序性能和用户体验。

- 2019年8月,宽带论坛(BBF)启动 了“Metro Computing Network(TR-466)”,主要研究算力网络在城域网中的场景和需求。

- 2019年11月,国际互联网工程任务组(IETF)发布Computing First Network系列个人文稿,主要研究算力路由协议。中国移动在 IETF 牵头推进需求、架构、试验等核心文稿和技术,共同举办了算力感知网络关键技术计算优先网络CFN的Side meeting。

- 2019年开始,国际电联电信标准化部门(ITU-T)分别在SG2组立项 M.rcpnm: Requirements for Computing Power Network Management,主要研究算力网络运营管理功能架构及功能需求,包括配置管理、故障管理和性能管理;在SG11 组启动了 Q.CPN 标准(算力网络的信令需求)与 Q.BNG-INC 标准(算力网络边界网关的信令要求)的制定等工作;在SG13 组从算力网络架构、算力感知网络相关技术等方面推进了 Y.CPN-arch 标准、Y.CAN 系列标准的制定工作。

- 2019年8月,中国通信标准化协会(CCSA)与国内中国移动,中国电信,中国联通三大运营商联合牵头在TC3立项 “算力网络需求与架构”研究项目,输出了一列的技术要求和研究课题(算力网络-总体技术要求、算力网络-控制器技术要求、算力网络-交易平台技术要求、算力网络-标识解析技术要求、算力网络-路由协议要求、算力网络需求与架构、算力网络开放能力研究)。

- 2020年5月,欧洲电信标准协会(ETSI)在在NFV ISG完成NFV support for network function connectivity extensions立项NFV-EVE020,以内容转发网络(CFN)为基础,研究 NFV的计算和网络集成相结合的网络功能连接扩展方案。

- 2022年7月,中国移动研究院在ITU-T SG13完成“云计算-算力资源抽象功能需求”标准立项,面向算力网络背景下的算力资源异构化、多样性的特点,提出算力资源抽象概念,并重点关注算力资源抽象的特征、功能需求和端到端业务场景。

- 2023年2月,中国移动研究院在CCSA完成“面向云计算的算力资源抽象模型总体要求”标准立项,重点研究算力抽象的统一架构要求、算力抽象编程模型及范式要求、算力抽象模型要求、运行时要求、跨架构编译要求、与算力管理平台协同要求等。

- 2023年3月,中国移动推动“算力路由”工作组在国际互联网标准化组织(IETF)成立,后续将负责算力路由相关标准的立项和制定。

算力网络相关产业进展

- 2021年6月,IMT-2030(6G)推进组发布《6G总体愿景与潜在关键技术》白皮书,将算力感知网络列为6G十大潜在关键技术之一。

- 2019年9月,边缘计算产业联盟(Edge Computing Consortium)与网络5.0联盟联合成立,将算力网络被视为未来网络发展重要方向。

- 2022年6月,中国信通院成立算力服务方阵,加速算力服务核心技术创新发展,构建算力服务新业态。

- 2022年6月,云计算标准与开源推进委员会开始进行可信算力标准体系研究,先后输出算力服务通用场景与总体框架以及可信算力服务-算力调度通用技术能力要求。

算力网络相关开源进展

- 2022年8月,OpenInfra Days China在中国召开,中国移动主导的算力网络工作组在OIF(开放基础设施基金会)宣布成立,线上分享算力网络相关技术,开源领域的发展,并讨论算力网络工作组后续的工作发展规划。

算力网络相关白皮书

- 2019年11月,中国移动发布《算力感知网络技术白皮书》,首次向业界介绍了算力感知网络(CAN, Computing-aware Networking)的背景与需求、体系架构、关键技术、部署应用场景及关键技术验证等内容。

- 2019 年 11 月,中国联通发布《算力网络白皮书》,阐述了未来算力业务形态、平台经营方式、网络使能技术等方面的观点。

- 2020 年 10 月,中国联通发布《算力网络架构与技术体系白皮书》,结合新基建等最新政策导向与 IPv6+时代可能的商业模式创新,阐述了中国联通算力网络架构设计、功能模型、层间接口与各功能层的关键技术,并结合若干场景对算力网络的应用和部署方式进行了展望。

- 2021年3月,中国联通发布《异构算力统一标识与服务白皮书》,在算力资源管理、业务建模和服务能力构建等领域为行业发展进行阐述。

- 2021年3月,中国联通发布《云网融合向算网一体技术演进白皮书》,在云网融合向算网一体演进的技术路线,关键能力等方面为行业发展进行阐述,旨在推动网络与计算深度融合,构建面向未来的算网一体化服务新格局。

- 2021年3月,中国联通发布《cube-net3.0 网络创新体系白皮书》,描述了可支撑包括算力网络在内的新一代数字基础设施的架构、技术体系、技术特征和服务特征。

- 2021年11月,中国移动发布《算力网络白皮书》,对算力网络的产生背景、核心理念、应用场景、发展路径以及技术创新进行系统阐述,提出“网络无所不达、算力无所不在,智能无处不及”的愿景。

- 2021年11月,中国移动发布《算力感知网络(CAN)技术白皮书》2021版,主要研究算力感知网络的架构、关键技术以及所面临的挑战,在算力感知网络体系架构、算力度量、算力感知、算 力路由、算力管理等方面进行探索。

- 2021年11月,中国移动发布《NGOAN智能光接入网白皮书》,主要阐述了对下一代光接入网发展的思考与最新成果,即可作为算力网络基础底座的千兆光网络,可用于构建“连接+算力+能力”的新型信息服务体系并提供可承诺的接入连接服务

- 2021年12月,中国联通发布《中国联通算力网络实践案例》,详细描述了联通省公司对算力网络资源感知、算力网络切片、算力网络云网安一体服务、全光算力网络等技术方案在具体场景中的应用及效果。

- 2022年5月,中国联通发布《算力网络可编程服务白皮书》,书在算力网络可编程服务理念,SIDaaS 技术体系,平台设计及实现机制等方面为行业发展进行阐述,旨在推动算力、服务和网络的统一编排与可编程调度,赋能面向未来的“大联接+大计算”数字信息基础设施发展新格局。

- 2022年6月,中国移动发布《算力网络技术白皮书》2022版,基于过去的研究成果,结合最新的政策、产业、标准发展情况,对算力网络的十大技术发展方向进行了展望,并阐述了算力网络的技术体系和技术路线。

- 2022年8月,中国移动发布《算网一体网络架构及技术体系展望白皮书》,从网络架构及技术创新发展的角度,提出算网一体的设计原则、定义、特征以及体系架构,并以此为基础阐述了算网一体的关键技术和发展前景。

- 2022年10月,中国联通发布《算力时代的全光底座白皮书》,定义了算力时代全光底座的五大关键特征,并从全光城市、全光枢纽、“东数西算”三个维度分别给出了全光底座的技术演进、架构布局和应用场景创新的方向。

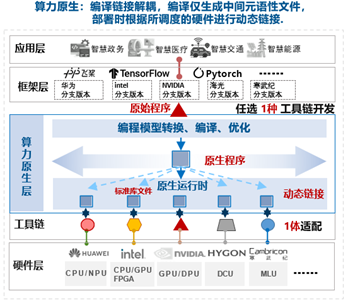

- 2022年11月,中国移动发布《面向智算的算力原生白皮书》,面向智算领域生态竖井问题提出算力原生理念,并系统性从算力原生的定义内涵、技术架构、演进路径、关键技术等方面进行了阐述,以便解决大规模、泛在多样的异构计算资源生态隔离问题,并实现应用跨架构无感迁移执行。

- 2022年12月,中国移动发布《算网大脑白皮书》,将算网大脑定位为整个算力网络体系的“智能中枢”,是算力网络编排管理层的核心,是算网共生发展的关键系统。中国移动提出以达成算网大脑“多样算力可泛在部署、极致网络可智能调度、算网资源可全局优化、算网能力可一体供给”为愿景,分阶段构筑融数注智的算网大脑,构建完整的算网大脑生态体系。

7. Reference

- 《中国算力发展指数白皮书》

- 《中国算力发展指数白皮书2022年》

- 《高性能计算云白皮书定稿》

- 《中国联通算力网络白皮书》

- 《算力网络架构与技术体系白皮书》

- 《算力网络技术白皮书》

- https://blog.csdn.net/ustc_dylan/article/details/121785732